很多 AI 创业者都笃信一件事——模型会降价。

只要模型降价,成本就会下降,今天勉强打平甚至亏损的收入状况,就会有好转。

生意就能做下去。

连 a16z 都在说,大语言模型成本正以每年 10 倍的速度下降。

问题是,模型真的一直在降价吗?

Substack 专栏《mandates》的这篇文章,则认为模型成本其实并没有在下降。「成本下降 10 倍是真实存在的,但仅限于那些性能老旧的模型。」

「市场的需求永远只针对*的语言模型。而*模型的成本始终大致相同。」

如果现状就是这样,AI 创业的商业模式要怎么变?文章也进行了探讨,或许,又回到了那句老话——AI 创业,*天就要考虑盈利。

假设你创办了一家公司,并且清楚地知道消费者每月的付费意愿上限是 20 美元。你可能会想,这没关系,是典型的风险投资打法:按成本收费,牺牲利润来换增长。客户获取成本 (CAC)、客户终身价值 (LTV) 这些账你都算过了。但有趣的是:你看到了 a16z 这张图表,大语言模型(LLM)成本正以每年 10 倍的速度下降。

于是你盘算着:现在以 20 美元/月的价格做到收支平衡,明年模型成本降低 10 倍后,利润率就能飙升到 90%。亏损只是暂时的,盈利是必然的。

这个逻辑简单到连 VC 助理都能看懂:

*年:以 20 美元/月实现盈亏平衡

第二年:计算成本下降 10 倍,利润率达到 90%

第三年:开始挑选游艇

这是一个可以理解的策略:「LLM 推理成本每 6 个月下降 3 倍,我们没问题。」

然而 18 个月后,利润率却前所未有地糟糕。Windsurf 公司已经倒闭清算,而 Anthropic 旗下的 Claude Code 也在本周被迫取消了其最初每月 200 美元的无限使用套餐。

行业仍在「亏损」。模型确实变便宜了,GPT-3.5 的成本只有过去十分之一。但不知为何,利润率反而变得更差了。

问题出在哪了?

01

降价的是旧版模型,

但没人用

GPT-3.5 的价格是比以前便宜了 10 倍,但它也像 iPhone 发布会上的翻盖手机一样无人问津。

当一款新模型作为*进技术发布时,99%的市场需求会立刻转移过去。消费者也期待他们使用的产品能做到这一点。

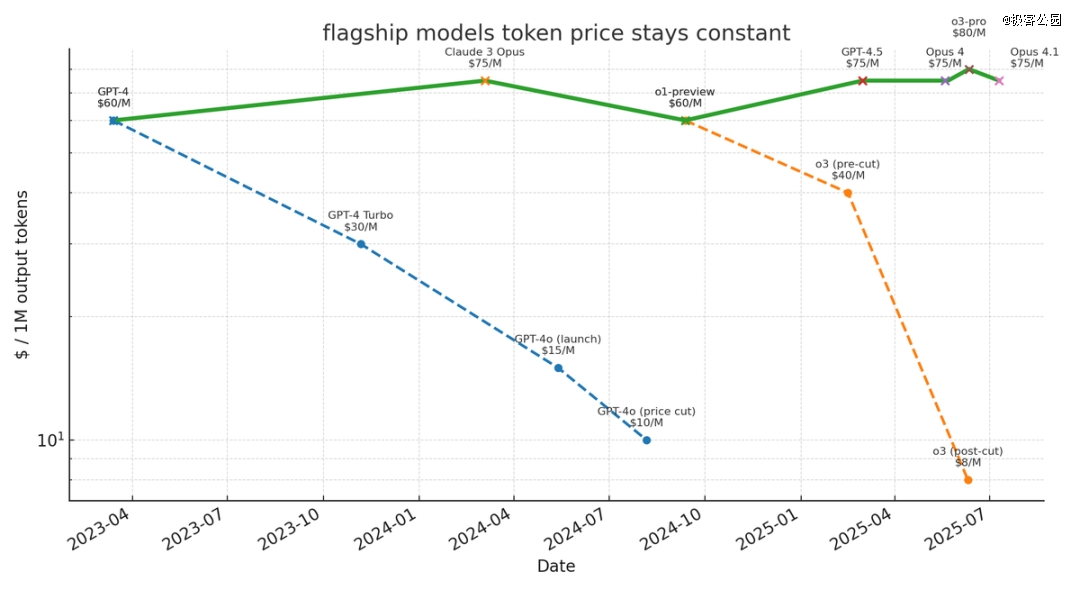

接着,我们来看看那些前沿模型的实际定价历史:

发现规律了吗?

当 GPT-4 以 60 美元的价格推出时,即便上一代的 GPT-3.5 便宜了 26 倍,用户还是毫不犹豫地选择了前者。

当 Claude 3 Opus 以 60 美元的价格登场时,即便 GPT-4 已经降价,人们还是转而投向了 Claude。

成本下降 10 倍是真实存在的,但仅限于那些性能老旧的模型。

所以,「成本会下降」策略的*个「支柱」就站不住脚:市场的需求永远只针对「*的语言模型」。而*模型的成本始终大致相同,因为它就代表了当前推理技术的成本边界。

指着一辆 1995 年的本田思域说「这车现在便宜多了!」完全是文不对题。没错,那辆特定的车是变便宜了,但 2025 年款丰田凯美瑞的官方建议零售价依然是 3 万美元。

当你花时间与 AI 互动时,无论是编程、写作还是思考,你总会追求最高质量。没有人会打开 Claude 然后想:「要不我还是用那个差一点的版本来给老板省点钱吧。」我们是认知上的「贪婪生物」,总想要能得到的*的「大脑」,尤其当另一端是我们宝贵的时间时。

02

模型的 token 消耗

远比我们想象的更多

我们可能会说,「好吧,但这仍在可控范围内,对吧?大不了就一直保持收支平衡?」但这种想法过于乐观了。

虽然每一代前沿模型的单位 token 价格确实没有变得更贵,但发生了另一件更糟糕的事:模型消耗的 token 数量出现了爆炸式的增长。

过去,ChatGPT 回答一个单句问题,回复也是一句话。而现在,一次「深度研究」会花 3 分钟规划、20 分钟阅读,再用 5 分钟为你重写报告;Claude 3 Opus 仅仅为了回答一句「你好」,就能运行 20 分钟。

强化学习和测试阶段计算量(TTC)的激增,导致了一个没人预料到的结果:AI能处理的任务长度每六个月就翻一番。过去返回 1000 个 token 的任务,现在需要返回 10 万个。

按照这个趋势推演下去,结果会变得非常惊人:

现在,一次 20 分钟的「深度研究」成本约为 1 美元。到 2027 年,我们将拥有能够连续运行 24 小时而不偏离主题的 AI Agent……如果结合前沿模型的固定价格,这意味着单次运行成本高达约 72 美元。而且是每天、每个用户,并能够异步运行多个 Agent。

一旦我们能够部署 AI Agent 异步执行 24 小时的工作,我们就不会只给它一个指令然后等待,而是会成批地调度它们。整个 AI 工作团队将并行解决问题,消耗 API 的速度堪比 1999 年的互联网泡沫时代。

必须强调的是,每月 20 美元的订阅费,甚至无法支撑用户每天进行一次 1 美元的深度研究。但这正是行业未来的方向。模型能力的每一次提升,本质上都是在提升其单次任务能「有效消耗」的计算资源量。

这就像你造出了一台更省油的发动机,然后用省下的能效去造了一辆怪兽卡车。没错,每加仑油能跑得更远了,但总油耗也增加了 50 倍。

这就是导致 Windsurf 陷入资金链危机的「流动性挤压」,任何采用「固定费率订阅 + 高价值高 token 消耗功能」商业模式的初创公司,都正面临着同样的威胁。

03

200 刀的 Claude Max 会员,

也抵不过「循环 tokens」用法

Anthropic 的 Claude Code 「无限量套餐」实验,是目前业内应对这场危机最复杂的尝试。他们几乎尝试了所有计策,最终仍以失败告终。

他们的策略确实相当巧妙:

定价提高 10 倍:当 Cursor 定价 20 美元/月时,Claude Code 定价 200 美元/月,为亏损预留了更多缓冲。

根据负载自动切换模型:负载过高时,从 Opus 模型切换到 Sonnet 模型(15 美元/百万 tokens );用 Haiku 模型进行阅读优化。这就像 AWS 的自动扩缩容,但服务对象是「大脑」。他们很可能将这种行为直接内置于模型权重之中,这将是一种我们可能会看到越来越多的范式转变。

将计算任务转移到用户设备:既然用户的 CPU 闲置着,何必再启动自家的沙盒环境?

然而,即便工程设计如此出色,token 消耗量依旧呈爆发式增长。

一百亿个 token,相当于在一个月内消耗了 1.25 万本《战争与和平》。

这怎么可能?即使用户每次运行 10 分钟,如何能消耗掉 100 亿个 token?

事实证明,10 到 20 分钟的连续运行时长,刚好够用户摸索出「循环 tokens」的用法。一旦 token 消耗与「用户在应用内的时长」脱钩,消耗就会失控:让 Claude 执行一项任务,检查成果、重构内容、优化细节,循环往复,直到公司破产。

用户摇身变成了「API 编排者」,用 Anthropic 的成本,24 小时不间断地运行代码转换引擎。从「聊天交互」到「Agent 自主运行」的演进一夜完成,token 消耗量激增 1000 倍,这是个阶段性的突变,而不是渐进式的。

因此,Anthropic 不得不取消无限量套餐。他们本可以尝试将定价提高到 200 美元/月,但关键的教训不在于「定价不够高」,而是在这个新世界里,没有任何订阅模式能够提供无限使用权限。

这意味着,在这个新世界里,没有一个固定的订阅价格是行得通的。商业模式的数学逻辑已彻底崩塌。

04

都知道要「按量定价」,

但没人敢先尝试

这让其他公司陷入了两难境地。

每家 AI 公司都知道,基于使用量的定价能救他们,但也知道这不成立。当你以负责任的 0.01 美元/1000 token 定价时,你的竞争对手却提供每月 20 美元的无限量使用。用户会选择谁?

这是典型的「囚徒困境」:

所有人都按使用量计费 行业可持续发展

所有人都按固定费率计费 陷入「比烂竞争」

你按使用量计费,别人按固定费率 你独自出局

你按固定费率计费,别人按使用量 你短期获胜

因此,所有人都选择了「背叛」。所有人都补贴重度用户,发布指数级增长的图表,并最终发布「重要的定价调整」公告。

Cursor、Lovable、Replit,它们都清楚其中的数学逻辑。但它们选择了「当下求增长,未来求盈利,把破产问题留给下一任 CEO」。

说实话这或许是对的。在「圈地运动」中,市场份额比利润率更重要。只要风险投资还愿意持续注资。

不妨问问 Jasper 公司,当资金链断裂时,会发生什么?

05

如何找到合适的商业模式?

有没有可能避开「token 流动性挤压」?

最近有传言称,Cognition 正以 150 亿美元的估值进行融资,而其年度经常性收入据称不到 1 亿美元(我猜可能更接近 5000 万美元)。相比之下,Cursor 在 ARR 达到 5 亿美元、增长曲线更陡峭的情况下,也仅获得了 100 亿美元的估值。Cognition 的收入不及 Cursor 的八分之一,估值却是其 1.5 倍。风险投资公司掌握了哪些我们不知道的信息?两家公司都主打「AI coding Agent」,难道 Cognition 找到了跳出「死亡螺旋」的方法?

目前有三种可能的出路:

从一开始就采用「按使用量计费」没有补贴,没有「先获取、后变现」的说法,只有诚实的经济模式。这在理论上听起来很棒。

但问题是:我们现在找不到任何一个采用「按使用量计费」且实现爆发式增长的消费级 AI 公司?消费者讨厌计量收费。他们宁愿为无限量套餐多付钱,也不愿意被意料之外的账单吓到。每一个成功的消费者订阅服务,Netflix、Spotify、ChatGPT,都是包月制。一旦你引入计量收费,增长就会停滞。

建立极高的切换成本,从而获得高利润率这是 Devin 的看好的方向。他们最近宣布了与花旗银行和高盛的合作,将 Devin 部署到每家公司的 4 万名软件工程师中。按每月 20 美元计算,这是一个千万美元级别的项目。但问题来了:你更愿意从高盛获得 1000 万美元的 ARR,还是从专业消费级开发者那里获得 5 亿美元? 答案是明显的:长达六个月的落地实施、合规审查、安全审计、繁琐的采购流程,意味着从高盛那里拿到的收入虽然难以争取,但一旦到手,客户就几乎不会流失。你只有在银行的*决策者将自己的声誉押注在你身上时,才能签下这些合同,而所有人都会竭尽全力确保项目成功。 这也是为什么除了科技巨头外,*的软件公司几乎都是「核心系统服务商」,例如客户关系管理、企业资源计划(ERP )、电子健康记录(EHR)系统。它们的利润率都能达到 80%-90%,因为客户切换成本越高,对价格的敏感度就越低。当竞争对手出现时,你的产品早已经深度嵌入到客户的业务流程中,切换供应商需要再经历一个为期六个月的销售周期。不是不能换,而是客户的 CFO 宁愿辞职,也不愿再经历一次供应商评估。

进行垂直整合,从基础设施上盈利这是 Replit 的玩法:将代码 AI 工具与应用托管、数据库管理、部署监控、日志记录等服务捆绑销售。在每个 token 上亏一点钱,但在新一代开发者的技术栈中,从其他所有环节捕获价值。看看 Replit 的垂直整合程度就知道了。

将 AI 作为「引流品」,推动用户使用其具有「类 AWS」竞争力的其他服务。你卖的不是「推理服务」,而是其他所有服务,推理成本只是营销开支。这个模式的巧妙在于,代码生成自然会增加对托管服务的需求。每个应用都需要运行环境,每个数据库都需要管理,每次部署都需要监控。就让 OpenAI 和 Anthropic 去把推理服务的价格竞争到零,你去做别的事情。

那些仍在坚持「固定费率、不计成本增长」模式的公司?它们只是「行走的僵尸」,只不过它们的葬礼定在了今年第四季度,并且成本高昂。

06

结语

我们不断地看到有创始人引用「模型明年会便宜 10 倍!」这种说法。但到那时,用户会期望得到 20 倍以上的回报。

还记得 Windsurf 吗?由于 Cursor 带来的对盈亏平衡的压力,他们根本找不到方法破局。即便是像 Anthropic 这样的公司,拥有全球最垂直整合应用层,也无法让一个提供无限使用量的固定订阅模式运转起来。

虽然《levered beta is all you need》文章的核心结论:「早入局胜过聪明」,仍然成立,但「没有规划地早入局」,只会更早地失败。谷歌不会为「负利润率业务」开出 24 亿美元的支票;当「以后再说」意味着你的 AWS 账单已经超过你的收入时,「以后」便不复存在。

那么,在这样的环境下该如何创业?简而言之,成为「新云厂商」。至少,模型明年的成本会降至 1/10。

免责声明:该文章系本站转载,旨在为读者提供更多信息资讯。所涉内容不构成投资、消费建议,仅供读者参考。